はじめに G検定とは何かと取得メリット

AI 活用の裾野が広がる現在、日本国内で最も受験者が多い AI 系資格が G検定(ジェネラリスト検定) です。

これは一般社団法人日本ディープラーニング協会(JDLA)が主催し、「AI で何ができるか」「どこに適用できるか」を判断できるリテラシーを証明する試験として 2017 年に創設されました。

累計受験者は 14 万人を突破し、2025 年 5 月実施の第3回試験では 4,284 名中 3,501 名が合格し、合格率は約 82 % に達しています。

G検定は 年6回(1・3・5・7・9・11 月) オンラインで実施され、受験資格は不問、受験料は一般 13,200 円(税込)です。

短い学習期間でも挑戦しやすく、学生・社会人を問わず受験者層が急拡大しています。

さらに本資格は、経済産業省と IPA が策定するデジタルスキル標準「Di-Lite」で推奨 AI 資格に指定され、全国の企業がリスキリング施策として導入しています。

社内研修費用を会社が負担する例や、合格を昇進条件に組み込む例も増えており、「AI 人材不足」の解決策として注目度が高まっています。

取得メリットまとめ

- キャリアアップと市場価値向上

AI プロジェクトの共通言語を習得できるため、職種を問わず DX 推進人材として評価されやすくなります。 - 社内外のネットワーク拡大

合格者コミュニティ「CDLE」に参加でき、最新技術や事例を共有する場で学び続けられます。 - E資格・Generative AI Test へのステップ

実装系資格や生成 AI 分野への発展学習にスムーズに移行でき、キャリアの選択肢を広げます。 - 企業の信頼獲得と案件受注

受託開発・コンサルティング企業では、提案書に取得者数を記載することで顧客の安心材料になり、競合優位性を高められます。

このように G検定は「AI 活用の第一歩」を公式に証明する資格として、個人と企業双方に大きなリターンをもたらします。

次章では、2025 年シラバス改訂で何が変わったのかを詳しく見ていきます。

2025年G検定の概要と新シラバス改訂ポイントを押さえる

2025年のG検定は、1・3・5・7・9・11 月の年6回実施という従来のペースを維持しつつ、試験時間120分・小問160問程度へと出題数が40問ほど削減されました。

オンライン受験・多肢選択式という形式は変わりませんが、問題当たりの思考時間がわずかに増えた分、「じっくり読ませるシナリオ問題」が増加した点が大きな特徴です。

受験料(一般13,200円・学生5,500円)は昨年と同額で、受験資格も引き続き不問です。

年間スケジュールを確認しよう

| 開催回 | 試験日 | 申込期間 | 特記事項 |

|---|---|---|---|

| 2025#1 | 1月11日(土) 13:00–15:00 | 11/15–12/27 | 新シラバス完全適用後初回 |

| 2025#2 | 3月7日(金) 16:00–18:003月8日(土) 13:00–15:00 | 1/17–2/27 | 金曜夜枠が復活 |

| 2025#3 | 5月10日(土) 13:00–15:00 | 3/14–5/2 | ゴールデンウィーク直後 |

| 2025#4 | 7月4日(金) 16:00–18:007月5日(土) 13:00–15:00 | 5/16–6/26 | 夏休み前の人気回 |

| 2025#5 | 9月6日(土) 13:00–15:00 | 7/11–8/29 | 直前期に模試が多い |

| 2025#6 | 11月7日(金) 16:00–18:0011月8日(土) 13:00–15:00 | 9/12–10/30 | 学習の総仕上げ |

ポイント

受験日は土曜13時開始が基本ですが、3・7・11月回には「金曜16時開始」が設けられています。

社会人は勤務調整が必要なので、早めに社内調整を行いましょう。

新シラバスで追加・強化された領域

| 技術カテゴリ | 主な新キーワード | 学習の観点 |

|---|---|---|

| 生成AI・基盤モデル | 大規模言語モデル(LLM)、拡散モデル、自己教師あり学習、RLHF | モデル構造や学習フローだけでなくリスクと活用事例の理解が必須 |

| AI倫理・AIガバナンス | ヘイトスピーチ検出、バイアス低減、レッドチーミング、AI監査 | 倫理的課題を事例ベースで問う設問が増加 |

| 法律・契約 | 著作権(プロンプト生成物)、個人情報保護、PL法、契約類型 | 生成物の権利帰属がホットトピック |

| 応用分野 | ロボティクス×生成AI、医療AIガイドライン、サプライチェーン最適化 | 実ビジネスでのROIや人材要件を問う |

受験対策へのインパクト

- 旧来の基礎暗記+過去問一辺倒は通用しない

生成AIや法律・倫理は時事問題色が強く、ニュース記事やホワイトペーパーに目を通しておく必要があります。 - シナリオ型問題への慣れが鍵

文章量が多い問題が増えたため、過去問演習では「設問ごとに読む→選ぶ」よりも段落単位で論点を即座に把握する速読トレーニングが有効です。 - 参考書・問題集も「2025年版」か要チェック

新旧シラバスが混在する旧版テキストでは、生成AIやAIガバナンスに関する記述が不足しがちです。

購入時には対応版を確認しましょう。

次章では、得点源として最も重要な「機械学習の基礎―教師あり学習の重要キーワード」を詳しく解説します。

得点源に直結する機械学習の基礎 教師あり学習の重要キーワード

教師あり学習とは何か

教師あり学習は、入力データ(特徴量)と正解ラベルのペアを与えて、未知データに対して正しい出力を予測できるモデルを学習する手法です。

G検定では「ラベル付きデータを使って未来を当てる技術」と覚えておくと理解しやすいです。

試験でよく問われるのは、回帰と分類という二大タスクの違い、そして各アルゴリズムの長所短所を整理できているかどうかです。

回帰と分類の違いを押さえる

| タスク | 目的変数 | 代表例 | 典型アルゴリズム |

|---|---|---|---|

| 回帰 | 連続値 | 売上予測・気温予測・不動産価格 | 線形回帰・SVR・ランダムフォレスト回帰 |

| 分類 | 離散ラベル | スパム判定・画像の犬猫判別・病気診断 | ロジスティック回帰・SVM・勾配ブースティング |

覚え方

- 回帰=「数値を当てる」

- 分類=「ラベルを割り当てる」

この区別を起点に、適切な評価指標(RMSE/MSE は回帰、正解率/F1 は分類)を結びつけておくと、設問を読んだ瞬間に選択肢を絞れます。

頻出アルゴリズムの要点と比較

線形回帰

- y = ax + b の一次式で近似

- 前提がシンプルで解釈性が高い

- 多重共線性や外れ値に弱い

ロジスティック回帰

- 出力を 0–1 の確率に変換して二値分類

- 係数の符号で「どの要因がプラスに働くか」を説明できる

- クラスが重なり合うと精度低下

サポートベクターマシン(SVM)

- マージン最大化により汎化性能が高い

- カーネルを変えるだけで非線形問題に対応

- サンプルが多いと学習コストが急増

決定木 & ランダムフォレスト

- ルールが木構造で可視化しやすい

- 単体の決定木は過学習しやすいが、バギング(ランダムフォレスト)で弱点を補完

- 変数重要度を算出でき、説明責任が取りやすい

勾配ブースティング(GBDT/XGBoost/LightGBM)

- 弱学習器を逐次追加し誤差を修正

- 表形式データの最強モデルとして実務で多用

- 過学習抑止のためのハイパーパラメータ調整が必須

評価指標と混同行列

- 回帰:MSE・RMSE・MAE

- RMSE は単位が元データと同じなので報告しやすい

- 分類:正解率・適合率・再現率・F1・AUC

- クラス不均衡がある場合は F1 や AUC を優先

- 混同行列 を描けると、偽陽性・偽陰性の数を一目で把握でき、医療系やクレジット審査の事例問題で有利

ビジネス応用例で理解を固める

| 業界 | ユースケース | モデル例 | 成果指標 |

|---|---|---|---|

| EC | レコメンド用購入確率予測 | 勾配ブースティング | CVR向上率 |

| 製造 | 設備故障時期の予測 | ランダムフォレスト回帰 | 稼働率・保守コスト削減 |

| 金融 | 与信スコアリング | ロジスティック回帰 | 貸倒率低減 |

| 医療 | 画像診断の病変検出 | SVM/CNN | 感度・特異度 |

実際のビジネス成果とアルゴリズムを紐付けて覚えておくと、シナリオ問題で「最適なモデルを選べ」という課題に強くなります。

学習のコツ

- キーワードをストーリーでつなげる

例)「教師あり → 回帰・分類 → 評価指標 → ビジネス効果」 - 数式より目線をデータフローに置く

入力→前処理→学習→評価→改善、の流れを説明できるようにする。 - 過去問+公式解説でアウトプット練習

問題文を読んだら「入出力は何?」「タスクは何?」を即答する癖をつけます。

次章では、教師なし学習とクラスタリング・次元削減の頻出テーマを攻略していきます。

教師なし学習とクラスタリング+次元削減で頻出テーマを攻略

教師なし学習は、ラベルのないデータから構造や規則性を見つけ出すアプローチです。

G検定では「クラスタリング」と「次元削減」が定番出題領域となるため、アルゴリズムの特徴とビジネス応用をセットで理解しておくと得点効率が飛躍的に高まります。

教師なし学習の全体像を整理する

- 入力は特徴量のみ

正解ラベルが存在しないため、外部情報に頼らず「データ同士の距離」「分散」を指標に構造を推定します。 - 主なタスクは二つ

- クラスタリング:似たサンプル同士をグループ化する

- 次元削減(可視化・圧縮):高次元データを情報を保ったまま低次元に写像する

クラスタリング ― 代表アルゴリズムと比較

| アルゴリズム | 特徴 | 弱点 | 典型用途 |

|---|---|---|---|

| K-means | 最も近い中心点へ割り当てを繰り返す | クラスタ数 kk を事前指定/非凸形状に弱い | 顧客セグメンテーション |

| 階層的クラスタリング(ウォード法など) | デンドログラムで統合過程を視覚化できる | 大規模データで計算量増大 | テキスト類似度分析 |

| DBSCAN | 密度ベースで形状に柔軟/外れ値検出 | 高次元データでパラメータ調整が難しい | 欠陥品・異常検知 |

必修ポイント

- エルボー法/シルエット係数で最適クラスタ数を評価できるか。

- 階層的クラスタリングは「木構造で分割の履歴が追える」ため、解釈性が高いことを一言で説明できると加点に直結します。

次元削減 ― 定番3手法をマスター

| 手法 | コアアイデア | 長所 | 短所 |

|---|---|---|---|

| PCA(主成分分析) | 分散が最大となる直交軸へ射影 | 計算が速い/線形変換で解釈容易 | 非線形構造を捉えにくい |

| t-SNE | 近接確率を保つよう低次元配置 | 局所構造が鮮明/可視化に強い | 計算負荷が高い/再現性低い |

| UMAP | 位相構造を保存しながら射影 | t-SNEより速い/グローバル構造保持 | 数理的背景が複雑 |

コツ

- PCA は「固有値が大きい=情報量が多い軸」とリンクづける。

- t-SNE は“クラスタ間の距離は信用し過ぎない”と覚える。

- UMAP は近年急増した設問で、「t-SNEと比べて速く再現性も高め」と答えられると差が付きます。

ビジネス応用でイメージを固める

- マーケティング:購買履歴 × K-means → 顧客をペルソナ化し、メール配信内容を最適化

- 製造業:センサ多次元データ × PCA → 故障予兆を早期検知、稼働率向上

- ネットサービス:閲覧履歴 × DBSCAN → 異常アクセスを自動隔離しセキュリティ強化

設問では「どのアルゴリズムを選ぶべきか」「評価指標として何を使うか」を問われるケースが多いため、ユースケース→適切な手法のワンセット暗記が有効です。

学習のコツ

- 手書きでフローチャートを書く

入力データ→距離計算→クラスタ割当 or 射影→評価、の流れをスケッチすると記憶が定着します。 - Python実装で動かす

scikit-learn のfit_predict()を一度でも実行すると、アルゴリズムの挙動が図解と結びつきます。 - グラフを見て説明する練習

t-SNE プロットを示され「この色分けは何を意味するか」を口頭で説明できれば、シナリオ問題に強くなります。

次章では、強化学習の仕組みとビジネス活用事例に踏み込み、ハイレベルな理解を目指します。

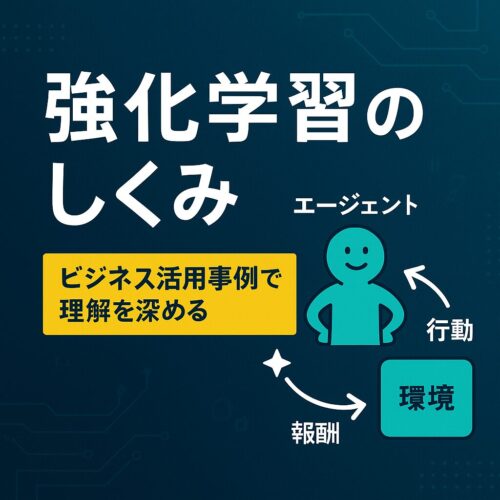

強化学習のしくみとビジネス活用事例で理解を深める

強化学習とは

強化学習は、環境と相互作用しながら報酬を最大化する行動方針(ポリシー)を学習する手法です。

教師あり学習・教師なし学習と異なり、正解ラベルは存在せず、エージェントが試行錯誤を通じて最適解を見つけます。

G検定では「状態・行動・報酬・遷移」という4要素を明確に説明できるかが必須ポイントです。

| 用語 | 意味 | 試験でのチェックポイント |

|---|---|---|

| 状態 sts_t | 現在の環境の情報 | 例:ロボットの座標、株価チャート |

| 行動 ata_t | エージェントの選択肢 | 例:前進・停止、買い・売り |

| 報酬 rtr_t | 行動後にもらえるスカラー値 | プラス報酬/ペナルティの違い |

| 遷移 | 次状態への移動確率 | 「マルコフ性」を言語化できるか |

価値関数とポリシー勾配の二大アプローチ

- 価値反復系(Q学習、SARSA)

- 状態–行動価値 Q(s,a)Q(s,a) をテーブルまたはディープネットで近似

- ε-greedy で探索と活用のバランスを取る

- 離散行動空間に強いが、高次元連続行動ではスケールしづらい

- ポリシー勾配系(REINFORCE、Actor–Critic)

- ポリシー π(a∣s)\pi(a|s) を直接パラメータ化

- 連続制御や確率的行動が得意

- 分散が大きく学習が不安定になりやすい→ベースライン減算で分散低減

覚え方

- Q学習=「表を埋めて最適解を探す」

- Actor–Critic=「行動を決める人(Actor)と採点者(Critic)の分業」

バンディット問題と探索戦略

- ε-greedy:確率 ε でランダム、1−ε で最高価値行動

- UCB(上信頼限界):平均報酬+探索ボーナスで未探索を優先

- トンプソンサンプリング:事後分布から確率的にサンプリング

試験では「広告バナーのクリックテスト」「ニュースレコメンド最適化」など、

試行回数が限られる場面でどの戦略を選ぶべきかを問う問題が頻出です。

ビジネス活用で差をつける

| 業界 | 具体例 | 使用アルゴリズム | KPI |

|---|---|---|---|

| EC | 動的価格調整 | Deep Q-Network | 粗利最大化 |

| 物流 | 自律搬送ロボット経路最適化 | Actor–Critic | ピッキング時間短縮 |

| エネルギー | スマートグリッド負荷分散 | 多腕バンディット | 電力コスト削減 |

| ゲーム | NPC 行動 AI | プロキシミティポリシー最適化(PPO) | ユーザー滞在時間 |

これらの事例を「状態・行動・報酬」で言い換えられるようにしておくと、シナリオ問題で満点を狙えます。

学習のコツ

- 紙に状態遷移図を書く

迷路や囲碁の盤面で、状態→行動→報酬を矢印付きで描くことで概念が定着します。 - Small GridWorld を実装

Python のgymnasiumで 4×4 グリッドを動かし、Q テーブルが更新される様子を確認します。 - ニュース記事で実例を追う

「リアルタイム入札広告 × 強化学習」など最新事例を読むと、

試験の法律・倫理問題にも強くなります。

モデル選択と評価指標を理解しシナリオ問題に強くなる

反復的プロセスで考える

- 目的設定:ビジネスゴール→タスク定義→評価指標を先に決める

- 特徴量・モデル候補の列挙:単純モデル→複雑モデルの順で比較

- 検証:ホールドアウト→k 分割交差→時系列交差(必要ならウォークフォワード)

- 過学習チェック:訓練誤差と汎化誤差のギャップをモニタリング

- 運用・監視:データ分布シフト検知→再学習スケジュール

評価指標の選択ガイド

| タスク | 指標 | 適用シナリオ |

|---|---|---|

| 回帰 | RMSE / MAE | 装置寿命予測(RMSE)/需要予測(MAE) |

| 二値分類 | AUC / F1 | 不均衡データの与信審査 |

| 多クラス分類 | マクロ F1 / ROC-AUC (OvR) | 画像分類 |

| レコメンド | MAP / NDCG | EC のランキング品質 |

| セグメントクラスタ | シルエット係数 | 顧客セグメンテーション |

試験必須ポイント

- AIC は汎化誤差の近似を通じてモデルの複雑性罰則を課す指標

- BIC はサンプル数が多いほど複雑モデルに厳しくなる

- オッカムの剃刀:複数の仮説が同精度なら最も単純なものを選択

過学習 vs 未学習

- 過学習(オーバーフィッティング)

- 訓練損失が小さいが検証損失が増大

- 正則化・ドロップアウト・アンサンブルで抑制

- 未学習(アンダーフィッティング)

- 訓練・検証ともに高損失

- モデルの表現力強化か特徴量追加が必要

現場で効く評価ワークフロー

- ベースライン = 小規模線形モデル

- まずはシンプルに動かし、目標指標との差を定義

- アブレーションテスト

- 特徴量やモデル構成を一つずつ外し、貢献率を可視化

- 再学習ポリシー

- バッチ学習+コンティニュアスデリバリーで概念ドリフトを監視

- 説明可能性(XAI)

- SHAP 値や部分依存プロットで意思決定プロセスを文書化

学習のコツ

- 過去問のシナリオ問題を声に出して要約

①ゴール ②データ特性 ③指標 ④最適モデル を30秒で説明できれば合格圏です。 - 自分の業務データで検証

手元の売上 CSV を使い、ホールドアウト→交差検証→最適モデル選択を

Jupyter ノートで再現すると理解が加速します。

まとめ 合格ライン突破までのロードマップ

- シラバスをマインドマップ化

全範囲を俯瞰し、出題ウェイトの高い順に学習計画を立てます。 - 基礎を 3 項目に集約

- 機械学習(教師あり/なし)

- 強化学習

- モデル評価

最低限ここを落とさないだけで合格点の 7 割近くを確保できます。

- 過去問 → 模試 → シナリオ演習 の三段ロケット

時間配分を体得し 90 分で 160 問を解き切る感覚を養います。 - 最新トピックを1日15分

生成AI・AI倫理・法律のニュースを継続ウォッチし、

「どの法律がどのリスクを抑制するか」を言語化できるようにします。 - 試験当日は“3周解法”で確実に得点

①即答できる問題を先に回収

②消去法で解ける中難度を処理

③最後に難問へ挑戦——この戦略で時間切れを防げます。

このロードマップに沿って学習すれば、合格率80%超の壁を越えるだけでなく、実務でも即戦力として評価されるAIリテラシーを獲得できます。

G検定合格を足がかりに、E資格や生成AI専門資格へとステップアップし、AI時代のキャリアを盤石に築き上げましょう。

>今回紹介したG検定の学習内容以外を学びたい方は、こちらからご覧ください👇